智谱的 CogVideoX,也就是「清影」同源模型,在本文发出时,开源了模型 已上 Github、Hugging Face

模型 A6000 单卡可跑可调

生成分辨率 720 * 480,6秒, 48帧训练数据来自互联网,B 站也提供了数据支持

*注1:推理均 21.6G,峰 36G,微调稳定 46.2G,在 A6000 范围内

*注2:坐等推理优化到峰值 24G 以内,就可以 4090 单卡跑了

本次开源:CogVideoX-2B

HF: huggingface.co/THUDM/CogVideoX-2b

Git: github.com/THUDM/CogVideo

本文后附:独家技术详解,含细节披露

顺道爆料:很快还有更大模型,会开源

短话长说

这几天在智谱玩得很开心:

- 在 智谱 DemoDay,以脱口秀演员身份,顶着「大聪明」名头….出道了

- PUA 智谱小伙伴,大半夜的,给这次的开源加 Feature

- 蹭了好几天的盒饭、零食、雪糕、快乐水

一些效果

提示词:A detailed wooden toy ship with intricately carved masts and sails is seen gliding smoothly over a plush, blue carpet that mimics the waves of the sea. The ship’s hull is painted a rich brown, with tiny windows. The carpet, soft and textured, provides a perfect backdrop, resembling an oceanic expanse. Surrounding the ship are various other toys and children’s items, hinting at a playful environment. The scene captures the innocence and imagination of childhood, with the toy ship’s journey symbolizing endless adventures in a whimsical, indoor setting.

提示词:The camera follows behind a white vintage SUV with a black roof rack as it speeds up a steep dirt road surrounded by pine trees on a steep mountain slope, dust kicks up from it’s tires, the sunlight shines on the SUV as it speeds along the dirt road, casting a warm glow over the scene. The dirt road curves gently into the distance, with no other cars or vehicles in sight. The trees on either side of the road are redwoods, with patches of greenery scattered throughout. The car is seen from the rear following the curve with ease, making it seem as if it is on a rugged drive through the rugged terrain. The dirt road itself is surrounded by steep hills and mountains, with a clear blue sky above with wispy clouds.

提示词:In the haunting backdrop of a war-torn city, where ruins and crumbled walls tell a story of devastation, a poignant close-up frames a young girl. Her face is smudged with ash, a silent testament to the chaos around her. Her eyes glistening with a mix of sorrow and resilience, capturing the raw emotion of a world that has lost its innocence to the ravages of conflict.

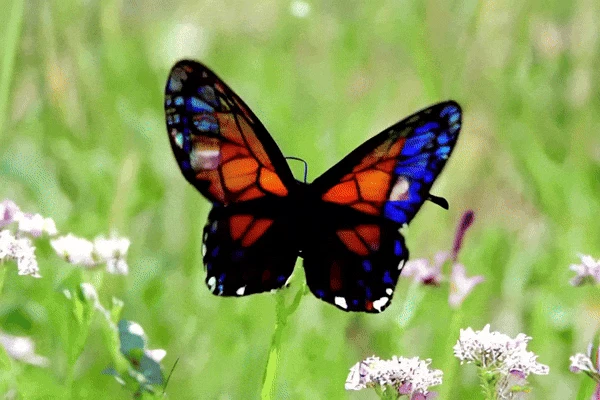

提示词:A single butterfly with wings that resemble stained glass flutters through a field of flowers. The shot captures the light as it passes through the delicate wings, creating a vibrant, colorful display. HD.

提示词:A snowy forest landscape with a dirt road running through it. The road is flanked by trees covered in snow, and the ground is also covered in snow. The sun is shining, creating a bright and serene atmosphere. The road appears to be empty, and there are no people or animals visible in the video. The style of the video is a natural landscape shot, with a focus on the beauty of the snowy forest and the peacefulness of the road.

提示词:Extreme close-up of chicken and green pepper kebabs grilling on a barbeque with flames. Shallow focus and light smoke. vivid colours

以下,是来自「赛博禅心」的独家信息

技术概览

- 架构:3D VAE + 专家 Transformer

- 限制:提示词上限为 226 tokens,长度 6 秒,帧率为 8,分辨率 720*480

- 显卡:FP-16 精度下:4090 可推理(21.6G / 24G),A6000 可微调(46.2G / 48G)

- 数据:训练数据来自互联网,共数万个小时,其中有来自B站的数据

- 标注:所用到的视频文本描述,由 AI 生成

- 训练:分为三个阶段:低分辨率训练、高分辨率训练和高质量视频微调

- 反馈:评估阶段,由 AI 和人类合作进行

更具体来说…

关于架构

3D VAE视频数据包含很多信息,所以需要很大的存储空间和计算能力。为了解决这个问题,3D VAE 的结构被用到,具体包含三个部分:

- 编码器 (Encoder):把复杂的视频转换成一个简化的代码。

- 解码器 (Decoder):根据这个代码重建出原来的视频。

- 潜在空间正则化器 (Latent Space Regularizer):确保编码器和解码器之间的信息传递更准确。

落地的时候,为了解决大分辨率泛化、增加帧数带来的困难,模型被分为两个阶段进行预训练(训练结束后,图像上还存在水印等信息),然后通过上下文并行在更高帧率上进行微调(画面更精细,且无水印)。

专家 Transformer使用专家 Transformer,通过以下流程,实现文字和视频的同时处理,并生成视频:

- 转换代码:首先,模型使用T5模型将文字和视频分别转换成代码。

- 结合代码:然后,将文字和视频的代码结合在一起。

- 多层次处理:专家Transformer模型有多个部分,每个部分负责不同的任务,如处理视频的空间和时间信息、控制信息流动等。通过多层次的处理,模型逐渐提取出更有用的信息。

- 生成视频:最后,将处理后的代码反向转换回原始形式,并生成最终的视频。

关于数据

训练数据来自互联网上的数万小时的视频,涵盖Vlog、动画片、纪录片等多种类型。经过场景检测工具处理,长视频被分割为单镜头片段,保留了部分包含场景转换的片段。随后,这些片段被进行筛选和重新描述。

视频筛选适合作为训练数据的视频,应该是真实世界的纪录片:动态连贯、自然。然而,大部分的视频并不达标。原因主要有二:

- 剪辑干扰:视频通常经过剪辑处理,包含如转场、拼接、特效等内容,不能准确映射真实世界

- 拍摄扰动:拍摄环境不可能完美,存在抖动、设备不佳等问题

于是,对于视频数据,需依据以下特征进行清洗:

- 转换代码:首先,模型使用T5模型将文字和视频分别转换成代码。

- 结合代码:然后,将文字和视频的代码结合在一起。

- 编辑痕迹:明显经过人工编辑、特效处理的视频。

- 缺乏运动连贯性:图像转换生硬、缺乏连贯性的视频,常见于人工拼接或编辑。

- 低质量:拍摄模糊、抖动严重的视频。

- 讲课类型:运动量少、以人物说话为主的视频,如教育内容、讲座等。

- 以文本为主:包含大量文字或主要聚焦于文字内容的视频。

- 噪声截图:来自手机或电脑屏幕的录屏视频。

最后,2 万个视频样本被进行标注,并基于 video-llama 训练了多个过滤器,用于自动筛选低质量视频。此外,还有个模型会对这些视频进行的光流和美学的打分,进行进一步筛选,以确保生成视频的流畅性和美感。

视频标注大多数几乎所有视频,都缺少准确的画面描述。所以,智谱的小伙伴训练了一个视频理解模型,用来生成对应的描述。具体步骤如下:

- 先利用 Panda70M 模型生成简短描述。

- 再使用 CogView3 生成密集图像描述。

- 然后用 GPT-4 总结所有图像描述,生成最终视频描述。

- 进而用这些描述,微调了一个 Llama 2 模型,实现了大规模视频描述数据的生成。

- 为进一步提升效率,使用 CogVLM2-Video 和 Llama 3,基于上述生成的描述,微调了一个端到端视频理解模型 CogVLM2-Caption。

通过在 10 万个视频上进行训练,使用 16*8 的 A100 集群,训练 10 个 epochs,最终实现了大量视频描述生成。

关于训练

训练方法在之前的视频训练中,会联合训练图像和固定帧视频,这也带来了两个问题:

- 由于图像和视频输入类型之间存在显著差距,图像有 1 帧而视频有几十帧,使得模型会根据输入类型,分裂成两种生成模式,泛化效果不好

- 对于固定时长的训练,短视频会被丢弃,长视频会被截断,导致了视频的帧数不能被充分利用。

为了解决这些问题,这次的模型选择了混合时长训练,并将不同长度的视频放入同一批次,以确保每批次内的形状一致,这种方法被称为帧包。注:图片可被视作单帧的视频

训练过程CogVideoX 的训练过程分为三个阶段:低分辨率训练(预训练)、高分辨率训练(预训练),高质量视频微调(最终微调)。1. 低分辨率训练在训练初期,模型会在较低分辨率下进行训练。这样可以使模型快速学习基本的图像和视频特征,减少计算资源的消耗。2. 高分辨率训练随着训练的深入,模型会逐渐在更高分辨率下进行训练。这一步骤能够帮助模型捕捉更细致的图像和视频细节,提升生成效果。3. 高质量视频微调在最终阶段,模型会使用一部分高质量的视频数据进行微调。这个过程能够进一步提升生成视频的视觉质量,并去除生成视频中的瑕疵,如字幕和水印。

关于评估

为了高效、准确地验证 CogVideoX 的效果,评估被分为两块:自动评估和人工评估。

1. 自动评估:通过动作、场景、动态度、多对象和外观风格等,交由 AI 进行评估生成视频的质量。2. 人工评估:除了自动化评估,研究团队还设计了一百组提示词,将生成的视频进行人工评估。

聚好用AI企业服务平台,企业落地应用大模型首选服务商

产品:大模型应用平台+智能体定制开发+落地咨询服务

承诺:先做场景POC验证,看到效果再签署服务协议。零风险落地应用大模型。